|

标签:服务器,云计算,数据中心,

在过去二十年中,行业标准服务器设计取得了重大进展,从1993年推出首款机架式服务器开始。从那时起,半导体制造和微处理器架构的技术进步推动了服务器设计的边界,该行业多年来一直推动性能,功率效率和成本节省的持续改进。按摩尔定律推动,这一进步速度已经成为企业信息技术从2000年代初开始增长和近年来公有云崛起的基石之一。

未来,随着行业加速从企业向云计算的转变,正在使用全球规模的公有云服务来构建新的解决方案,为客户提供全新的产品体验。提供这种全球规模服务的数据中心基础设施也在快速发展,硬件技术的相应创新水平不同于之前在行业中所见到的。在公有云的快速增长和扩展工作负载的推动下,我们现在处于计算架构革命的临界点,这将彻底重新定义“服务器”的经典概念。

新的超高速工作负载的出现

公有云现在在三个主要方面发展:企业工作负载到云迁移的基础架构即服务(IaaS),用于构建云本机应用程序的平台即服务(PaaS)专为全球规模的容错而设计,以及软件即服务(SaaS),可提供全面的交钥匙解决方案的云产品。云计算的初始需求主要由IaaS驱动,但最近PaaS和SaaS正在成为破坏性创新的关键点,以便在各种市场垂直领域使用这些服务。如用于图像,视频和语音处理的机器学习算法的认知服务,用于诸如喷气发动机和连接汽车的商业场景的物联网(IoT)服务。

新兴的云服务与传统的“遗留”IaaS应用程序在如何利用底层硬件资源方面截然不同。这些高度并行的工作负载在数据中心的数百台(有时甚至数千台)机器上运行,需要大量的网络带宽和计算资源。其中一些工作负载流量大量实时数据,需要在存储之前立即执行。大多数这些工作负载可以完全在服务器的输入/输出(I/O)中运行,并且在很多情况下操作不能很好地映射到当前微处理器设计的架构。这些数据中心工作负载的另一个属性是在大规模服务器与服务器间通信(也称为数据中心开销)时,对于所有数据传输和闲置数据进行集中操作(如压缩和加密)所产生的处理开销。

这些下一代云工作负载正在推动对有效地托管这种分布式横向扩展应用程序所需的计算架构和硬件架构的全面重新思考。

超越经典的冯诺依曼瓶颈

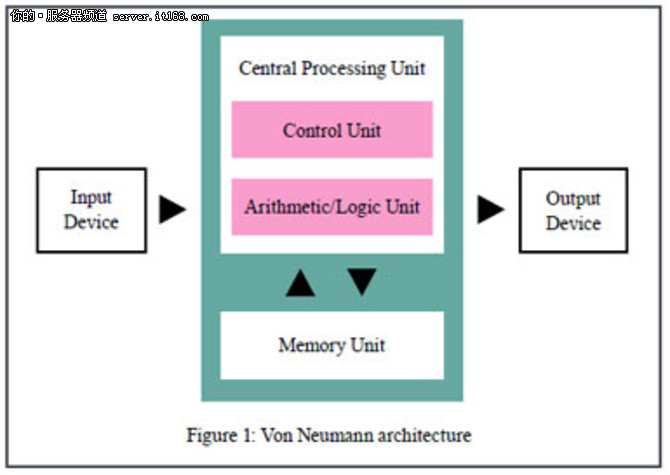

设计高性能硬件来承载这种超高速服务需要重新评估底层计算架构的基本原理。当前的服务器系统基于冯诺依曼(Von Neumann架构起源于1945年),并且由连接到服务器的计算,内存和输入/输出(I/O)设备之间的明显分隔来定义(见图1)

▲

在这样的机器中,冯诺依曼瓶颈被定义为由计算发生在哪里和存储数据的“chokepoint”产生的对性能的限制。

▲

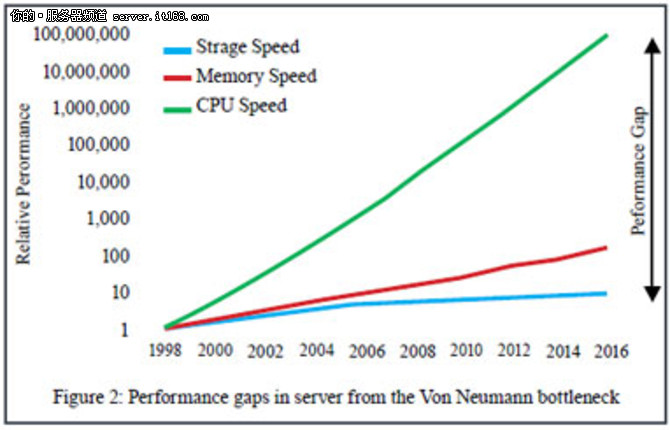

迄今为止,硬件行业已经使用诸如更大的微处理器高速缓存,多线程,多核和3D封装等技术解决了这个瓶颈。但瓶颈依然存在,并导致摩尔定律对晶体管的收益效率低下。最终的结果是,目前的服务器设计无法使用过去运行良好的“一刀切”的方法有效地执行全面的云计算工作负载。这对数据中心基础设施的总体拥有成本(TCO)有重要的影响,业界势必要将计算范式和相关的硬件设计发展到超越当今冯?诺依曼(Von Neumann)架构的局限。

前方的路

为了满足这些新的计算挑战,硬件行业正在响应各种各样的架构选择,每个都针对特定Hyperscale工作负载的高性能执行进行调整。一些示例是用于加速计算和网络处理的FPGA,用于机器学习的GPU和数据流引擎,用于高吞吐量模式处理的内存处理设计和用于人工智能的神经元计算。虽然没有一个单一的“银弹”体系结构可以很好地映射到所有的工作负载,但是观察到的趋势是经典的冯·诺依曼(Von Neumann)架构与其他计算架构的创新融合。

这是引领行业步入破坏性创新和大规模实验的新时代。创业公司正在获得资助,以探索具有定制芯片设计的系统的突破性想法,硅供应商正在大力投资来解决这些新工作负载并扩大其产品路线图,而大型云服务提供商(CSV)正在部署这样的混合计算架构,以提供全新的云服务,同时提高运营利润。这样的趋势已经导致很多的兼并和收购,因为现有的玩家需要保持领先并保护其细分市场。随着这种趋势的进展,“服务器”的经典概念被重新定义为以前难以想象的方式。

在过去二十年中,服务器行业已经取得了可预测的节奏,随着摩尔法律的增长而逐渐改善。随着基于新兴Hyperscale服务的云计算和垂直解决方案的增长,未来几年将见证从传统服务器设计到针对大规模计算优化的创新型新架构范式的根本性变化。预计这种趋势将进一步加速公有云服务的采用,因为只有大型CSV才能拥有规模和能力来维持有效设计和提供下一代数据中心基础架构所需的大量研发投入。我们正处于计算架构革命的边缘,我们现在所知道的“服务器”将不再存在于这个新兴的超级服务领域。

作者:微软Azure硬件基础架构总经理Kushagra Vaid

|